Algorithmus und Bias - was bedeutet das überhaupt?

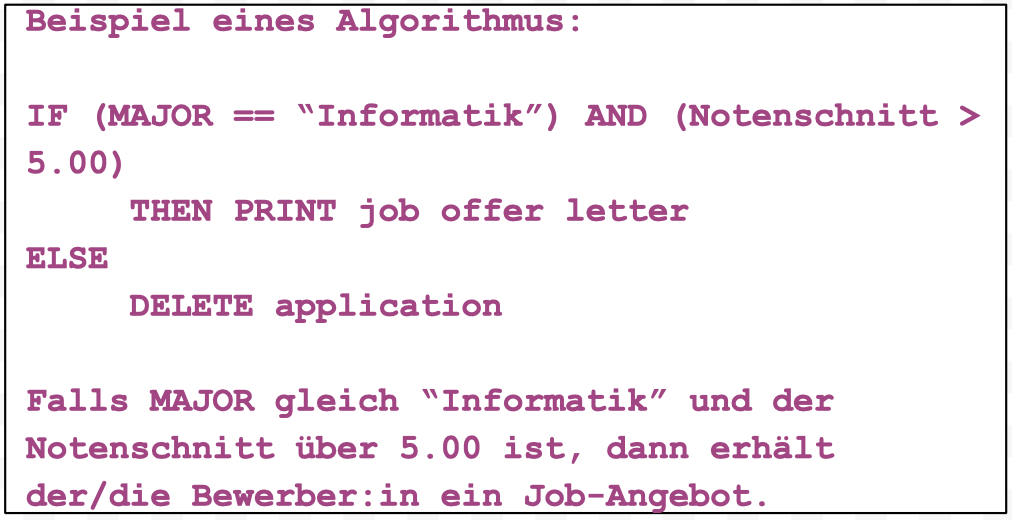

Ein Algorithmus ist eine Reihe von konkreten Schritten, die dazu dienen, eine Aufgabe zu lösen. Machine Learning ist eine bestimmte Klasse von Algorithmen, die Teil der Künstlichen Intelligenz (KI) sind. Sie finden Muster in Daten und nutzen diese, um sogenannte «predictive models» zu erstellen. Diese «predictive models» reichen von einem einfachen Set an Regeln (IF “x” THEN “y” ELSE “z”) bis hin zu komplexen Modellen. Diese Regeln/Modelle bilden häufig algorithmische Voreingenommenheiten oder sogenannten «Bias». Als Bias bezeichnen wir alles, was eine unfaire Handlung oder Darstellung verursacht, die meistens einem Menschen oder einer Menschengruppe Schaden zufügt.

Ein Beispiel dafür wäre es, wenn ein Schweizer und ein Nicht-Schweizer sich auf die gleiche Stelle bewerben. Beide haben Informatik studiert, weisen die gleiche Erfahrung auf und haben einen Notenschnitt über 5.00. Wäre der Algorithmus voreingenommen, könnte er beispielsweise den Schweizer Bewerber bevorzugen. Eine solche Handlung ist unfair, wenn im Endeffekt nur die Nationalität den Einstellungsentscheid beeinflusst hat. Wenn ein Algorithmus diese unfaire Handlung oder Darstellung produziert, bezeichnet man dies mit «Algorithmic Bias». Unsere Recherchen und Interviews haben ergeben, dass Menschen bei einem menschlichen Bias viel toleranter sind als gegenüber einem algorithmischen Bias. Mit anderen Worten erwartet man von einer Maschine, dass sie stets fehlerfrei und unvoreingenommen entscheidet. Bei Menschen hat man allerdings Verständnis, wenn sie Fehler machen.

Wir Menschen sind viel toleranter gegenüber einem menschlichen Bias als einem «automatisierten» Bias.

Die HR-Branche im Fokus

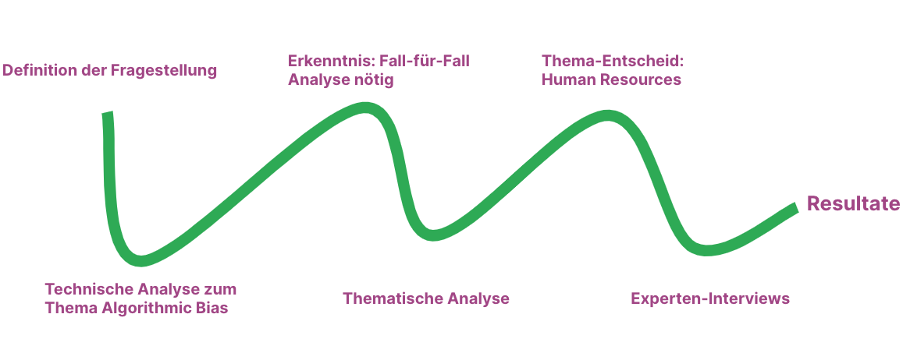

Im Rahmen des Algorithmic Bias Projektes, befassten wir uns sowohl mit den technischen Aspekten als auch mit den ethischen, gesellschaftlichen und den bestehenden und bevorstehenden Schweizer Gesetzen. Dafür haben wir Stakeholder-Interviews mit Experten aus Industrie, Wissenschaft, Gesellschaft (Non-Profit Organisationen), Recht und Politik geführt. Nach der technischen Analyse kamen wir zum Schluss, dass ein branchenübergreifender Lösungsansatz nicht zielführend ist. Algorithmen haben ein sehr diverses Einsatzgebiet und können je nach Verwendung direkten Personenschaden anrichten. Deshalb ist es sinnvoll, wenn man beispielsweise autonome Fahrzeuge anders als algorithmisch-gestützte HR-Entscheide behandelt und somit auch dazugehörige Analysen sektoriell beziehungsweise Fall-für-Fall durchführt. Diese Erkenntnis kann auch im Projektverlauf in Abbildung 1 nachvollzogen werden.

Unsere thematische Recherche hat uns motiviert, den Use-Case «Human Resources» näher zu betrachten. Fast jede Person durchläuft mindestens einmal in ihrem Leben einen Bewerbungsprozess. Latente Voreingenommenheiten können über die wirtschaftliche Existenz und die Integration dieser Personen entscheiden. Schon heute treten menschlich induzierte Voreingenommenheiten wie zum Beispiel Rassismus auf. Da Machine Learning die Modelle und Regeln aus vorhandenen Daten baut, besteht das Risiko, dass existierende menschliche Voreingenommenheiten in algorithmische Entscheidungen mit eingebaut werden.

HR-Manager bleiben diskret

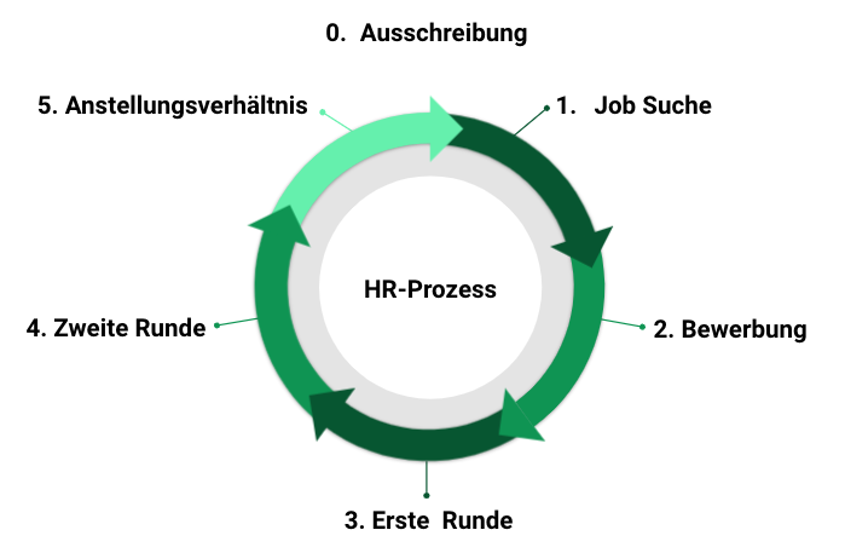

Wir haben den HR-Prozess in der Schweiz genauer analysiert (Abbildung 2) und festgestellt, dass in allen Schritten einer Bewerbung Algorithmen eingesetzt werden können. Schon bei der Jobbeschreibung (sozio-kulturelle Attribute), bei der CV-Analyse, bei automatisierten Assessments und maschinell ausgewerteten Interviews kann deshalb eine Diskriminierung durch Algorithmen auftreten.

In der Schweiz benutzen mehrheitlich grosse Unternehmen automatisierte HR-Systeme, da sie sich davon steigende Effizienz und niedrigere Kosten erhoffen. Kleinere und mittelgrosse Unternehmen (KMU) haben für grosse Automatisierungen in HR entweder kein Bedürfnis, da sie jährlich nur eine Handvoll Mitarbeiter einstellen oder sie lagern diesen Prozess aus Know-How- und Ressourcengründen aus. Da die meisten Unternehmen den Einsatz solcher Systeme verdeckt halten, war es für uns sehr schwierig, genaue Zahlen auszuarbeiten. Aus unseren Interviews konnten wir festhalten, dass die HR-Manager das Risiko eines Reputationsschadens aufgrund voreingenommener HR-Systeme nicht in Kauf nehmen wollen. Des Weiteren zeigten die Interviews, dass die Akzeptanz für den Einsatz solcher Systeme bei der Schweizerischen Bevölkerung noch sehr klein ist.

«Ein Stellensuchender ist kein professioneller Stellensuchender, während ein Recruiter professionell nach Bewerbern sucht.»

Der Bewerbungsprozess ist rechtlich gesehen nicht vertraglich abgedeckt. HR-Entscheide sind für die Bewerber meist intransparent. Tatsache ist, dass HR-Manager und Recruiter professionell täglich nach Bewerbern suchen bzw. CV’s beurteilen, während Bewerber/-innen in der Regel jeweils alle 2-3 Jahre den Bewerbungsprozess wenige Male durchlaufen. Für Bewerber/-innen ist es schwer zu erkennen, ob sie beim Entscheid durch den HR-Manager diskriminiert wurden oder nicht. Dadurch ist es für den Bewerber fast unmöglich, eine Diskriminierung nachzuweisen und im Sinne des Diskriminierungsverbotes (Art. 8 BV) sein Recht einzufordern.

Automatisierte Entscheidungen und das Datenschutzgesetz

Daten spielen eine zentrale Rolle im Lernprozess von KI-Systemen. Aus diesem Grund kann man die Diskussionen um das Sammeln und Nutzen von Daten nicht vernachlässigen, wenn man algorithmische Entscheidungen analysiert. Generell ist der Umgang mit Daten in der Schweiz im Vergleich zu Europa eher liberal. Das bestehende Datenschutzgesetz aus dem Jahre 1993 ist veraltet und erzielt in seiner heutigen Form eher limitierte Wirkung. Dies wurde von der Politik bereits aufgenommen: das Datenschutzgesetz wurde revidiert und an das strengere, europäische Datenschutzrecht (die EU Datenschutzgrundverordnung) angepasst. Es wird voraussichtlich 2023 in Kraft treten.

Das neue Datenschutzgesetz lässt jedoch für Firmen und Gerichte bezüglich der Definition der «automatisierten Entscheidung» viel Spielraum offen. Die Rechtsexperten sind sich nicht einig, zu welchem Grad ein menschlicher Zwischenschritt oder eine menschliche Beteiligung die Entscheidung beeinflussen muss, damit sie nicht mehr als automatisiert gilt. Da das Gesetz zwischen automatisierten und nicht-automatisierten Entscheidungen unterscheidet, ist es für Bewerber/innen und für den Bewerbungsprozess sehr relevant. Nur bei einer automatisierten Entscheidung schreibt das Gesetz eine Informationspflicht des Arbeitgebers an den Bewerber vor, und ermöglicht es dem Bewerber, den Entscheid durch eine natürliche Person überprüfen zu lassen.

Bei automatisierten Einzelentscheidungen besteht zum Beispiel eine Informationspflicht des Betroffenen (Art. 21 neues DSG). Des Weiteren wird dem eidgenössischen Öffentlichkeits- und Datenschutzbeauftragten (EDÖB) sehr viel Verantwortung zugesprochen. So besteht die Möglichkeit, branchenspezifische Verhaltenskodizes zu bestimmen im Sinne eines Soft-Law, welches der EDÖB überprüfen und dazu Stellung nehmen muss (Art. 11). Weiter wird der EDÖB unter anderem damit beauftragt, Konsultationen für Organisationen und Firmen durchzuführen (Art. 24) und ist die nationale Anlaufstelle für jegliche Verletzungen der Datensicherheit (Art. 25). Die heute bestehenden Ressourcen des EDÖB reichen unserer Meinung nach nicht aus, um alle Aufträge zuverlässig zu erfüllen.

Politik und Industrie sind zögerlich

Anhand der Interviews konnten wir feststellen, dass sowohl die Politik als auch die Industrie im Vergleich zu Europa und den USA momentan eher passiv unterwegs sind. Einerseits möchte die Politik möglichst liberal bleiben und nur das regulieren, was nötig ist. Andererseits hütet sich die Industrie vor Reputationsschäden und möchte die Systeme erst breitflächig einsetzen, wenn die Bevölkerung die nötige Akzeptanz zeigt. Ein weiterer wichtiger Punkt für die Industrie ist, dass der rechtliche Rahmen klar definiert sein muss. Beide Seiten warten auf eine öffentliche Debatte in der Schweiz, von der sie sich mehr Klarheit erhoffen. Dies könnte dazu beitragen, mehr Transparenz über KI-Modelle und deren Einsatzgebiete zu schaffen. So ist es für die betroffenen Nutzer nicht nur wichtig den KI-Modellen zu vertrauen, sondern auch zu wissen, wann und für welche Aufgaben sie eingesetzt werden.

Industrieverbände und (internationale) Institutionen sind bestrebt Guidelines und ethische Chartas zu erlassen (Soft Law), um das Vertrauen in die Nutzung der Technologie zu erhöhen. Eine konkrete Möglichkeit wäre, regelmässige Audits der KI-Systeme durch externe Firmen oder den Staat zu fördern. Ein weiterer Schritt für die HR-Manager wäre einen gewissen Anteil an Zufall in automatisierte HR-Prozesse einzubauen. Zum Beispiel könnte das Resultat der automatisierten Lebenslaufanalyse durch eine bestimmte Anzahl zufällig ausgewählter Lebensläufe erweitert werden. Dies gibt den HR-Managern ein Gefühl dafür, wie das System die vorgeschlagenen Lebensläufe auswählt und ob ein Bias erkennbar ist.

Vorteile von automatisierten Entscheidungen im Gegensatz zu menschlichen Entscheidungen:

- Sie sind transparenter - jede Entscheidung kann überprüft werden

- Sie sind zuverlässiger über die Zeit

- Voreingenommenheiten können theoretisch gezielt behoben werden

Eine nationale Debatte ist notwendig

Der Bias in automatisierten Systemen ist für die Gesellschaft ein wichtiges Thema. Der Einfluss von KI-Systemen ist durch die Skalierbarkeit der Technologie gross, weil solche Systeme massiv mehr Bewerbungen analysieren können als HR-Manager. Ein bereits bestehender Bias, der in den Daten implizit vorhanden ist, kann massiv verstärkt werden. KI-Systeme haben zwar ihre Berechtigungen und können der Gesellschaft durchaus einen grossen Nutzen bringen. Jedoch ist es wichtig, dass wir diese verantwortungsvoll einsetzen und sie so wenig Bias wie möglich beinhalten. Es gibt noch weitere Fragestellungen, die wir im Rahmen dieses Projektes nicht beantwortet haben und die vertiefter analysiert werden müssen. So ist zum Beispiel die Transparenz wichtig. Wie aber kann man sie bei komplexen «Black-Box»-Modellen, wie sie in den Bewerbungsprozessen eingesetzt werden, erreichen? Auch stellt sich die Frage, ob es jemals komplett faire Algorithmen und Datensätze geben wird? Des Weiteren haben wir erwähnt, dass eine nationale Debatte notwendig erscheint. Mit diesem Projekt haben wir einen Schritt in diese Richtung gemacht.

Unsere Vorschläge

... an Juristen und Politik

- Arbeitnehmer bzw. Bewerber müssen mehr Beschwerdemöglichkeiten haben

- Eidgenössischer Datenschutz- und Öffentlichkeitsbeauftragter (EDÖB) muss massiv mehr Ressourcen erhalten

- Eine öffentliche Debatte muss initiiert werden

... an die Industrie

- Mehr Transparenz bezüglich Prozesse und Einsatz von Algorithmen um Vertrauen aufzubauen

- Vertrauen ist nötig für weite Akzeptanz

- Eine Mischung aus automatisierten und manuellen Entscheidungen

Weitere Details zu unserem Projekt wurden im «Weiter wissen Podcast» diskutiert: Wenn Künstliche Intelligenz über Bewerber*innen entscheidet

Die Beiträge auf dem Reatch-Blog geben die persönliche Meinung der Autor*innen wieder und entsprechen nicht zwingend derjenigen von Reatch oder seiner Mitglieder.

Comments (0)